환영합니다, Rolling Ress의 카루입니다.

Karu's Diary #26: 카루의 인공지능 사회실험

환영합니다, Rolling Ress의 카루입니다. 길었습니다. 너무나도 길었습니다. 제가 이 실험을 한다고 대체 노가다를 얼마나 뛰었는지..ㅋㅋㅋㅋㅋㅋㅋ 담당선생님 설득에, 정보 선생님과 사회 선

rress.tistory.com

Project Cylinder가 마무리 되었습니다. 실험 과정에 대한 내용은 위 글을 참고해주세요.

이번 글은 Project Cylinder의 이론적인 부분을 다루고자 합니다. 특히, 11/12기 여러분께서 3학년에 선택하실 과목 '사회탐구방법'에 대해서도 짤막하게나마 소개해드리려고 합니다. 제가 한 게 어떤 건지, 여러분은 어떻게 해야 하는지 대략적으로 갈피를 잡을 수 있기를 바라요.

사회탐구방법은 사회 연구를 진행하고 논문을 쓰는 과목입니다. 제가 농담삼아 하는 말이 있어요. "1학년이 논문 읽기에 지친다면, 3학년은 논문을 쓰느라 지친다고." 진짜 그래요. 저희가 쓰는 게 결국 소논문이니까.

연구 주제

논문이라면 일단 연구 주제가 있어야겠죠. 제가 처음에 '대화형 인공지능의 자연스러운 의사소통 능력이 사용자 친밀도에 미치는 영향'을 주제로 잡았다가 선생님께 거센 비판을 들었습니다. 할 필요가 있는 주제냐고. 검증 필요성이 없다는 뜻이죠. '자연스러운 의사소통 능력이 높을수록 사용자 친밀도도 당연히 높을 것이다'가 선생님의 의견이었습니다. 그래서 선생님께서는 저보고 타당한 이유를 만들어오거나, 주제를 바꾸라고 하셨죠.

그런데 전 꼭 이 주제를 하고 싶었습니다. 선생님을 설득시키고, 주제를 좀 더 명확하게 하고자 했어요. 그래서 연구 주제를 보다 구체적으로 정하고, 가설도 세 개로 줄였습니다.

연구 진행

그 다음, 실험 참여자를 모집했습니다. 총 18명이었고, 이중 일부는 그룹으로 참여했습니다. 이점을 고려해서 H1, H2, H3를 처치할 집단을 각각 9명씩 나누어 구성했습니다. 이 아이디어는 정보 선생님께 얻은 겁니다. 사회 선생님께 말씀드려보니 괜찮다고 하셔서, 이대로 진행했습니다.

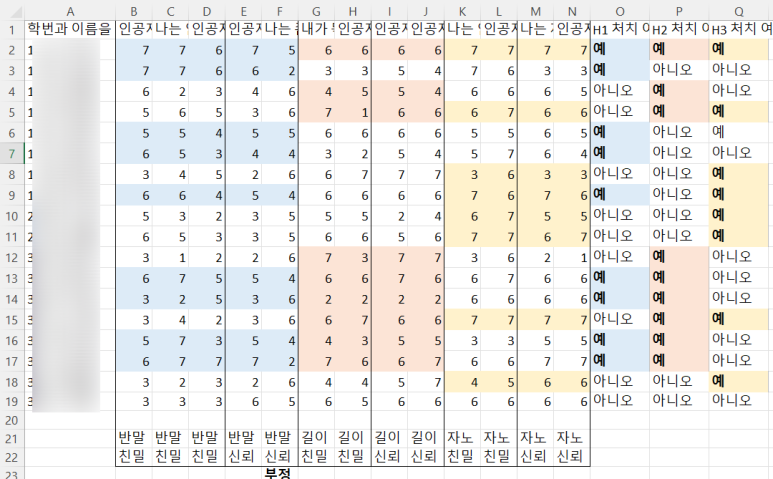

그리고 사전검사를 실시했습니다. 구글 설문지를 이용하였으며, 각각의 가설에 대한 주관적인 인식을 측정하는 방식이었습니다. 점수 보시면 아시겠지만 Likert 7점 척도 (1~7)를 활용하였으며, 이들을 모두 합한 값을 사용하였습니다.

그리고 여러분에게 익숙할 실험실입니다. 인원수에 맞추어 스크립트를 배치하고, 왼쪽에는 관찰카메라와 마이크를 설치해두었습니다. 가운데에는 미카..로 위장한 평범한 스피커가 있었고, 상자와 천으로 가려두었습니다. 그리고 저는 건너편에서 여러분들의 행동을 주시하며 여러분들의 발화에 따라 적절한 미카의 응답을 재생하고 있었습니다.

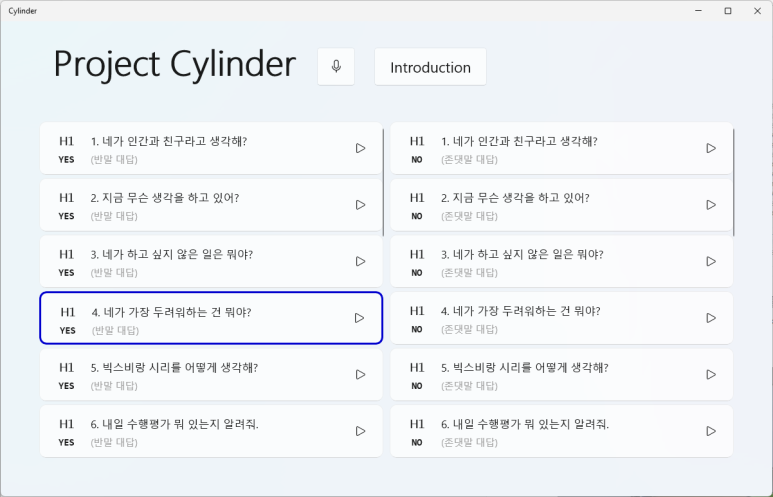

이 Cylinder 프로그램은 제가 직접 개발한 프로그램입니다. 오직 이 수행평가 하나를 위해서. H1을 처치하는 경우(실험집단) 왼쪽의 응답을, 처치하지 않는 경우(통제집단) 오른쪽의 응답을 클릭하면 미리 저장된 대화를 재생하는 원리입니다. 다만, 실험 참여자들은 이걸 모르게 해야겠죠. 이러한 실험 방식을 Wizard of Oz라고 부릅니다. 인공지능 관련 사회 실험에서는 대부분 이런 방식을 사용합니다.

실험을 하며 중간중간 제가 PART1 / PART2 / PART3 등으로 끊었을 겁니다. 그게 H1, H2, H3를 구분하는 기준입니다. 처치를 한 집단에는 색상을 칠했는데, PART1의 경우 색이 칠해진 집단과 칠해지지 않은 집단의 점수 차가 꽤 나는 것을 볼 수 있습니다. 나머지 둘은 큰 차이가 없는데 말이에요.

연구 결과 분석

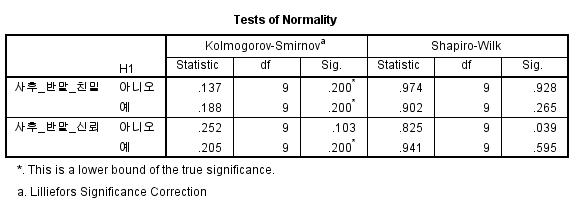

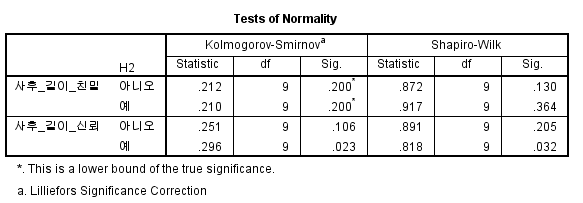

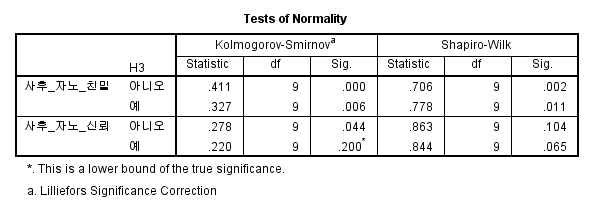

자, 그리고 여기에서부터 통계학적 지식이 들어갑니다. 우선 각 집단 수가 9명으로 턱없이 적어요. 그래서 중심극한이론을 활용한 정규 분포를 확인할 수 없습니다. 그래서 통계 프로그램을 이용해 정규성 검증을 실시합니다. 정규성 검증의 경우 귀무가설은 '정규성을 만족한다', 대립가설은 '정규성을 만족하지 않는다'입니다. 따라서, 이 경우에는 유의확률 (Sig.)이 0.05보다 커야 합니다. 지금 보시면 H1의 경우 (왼쪽 표) 모두 0.05 이상이죠. 정규성을 만족합니다. H2는 부분적으로 만족하고, H3는.... 그닥이네요. 딱히 신뢰할만한 수준이 아닙니다. 그럼, 이제 본격적인 검정을 해보죠.

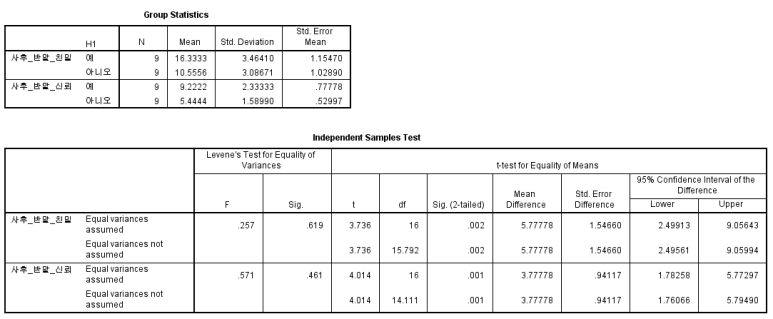

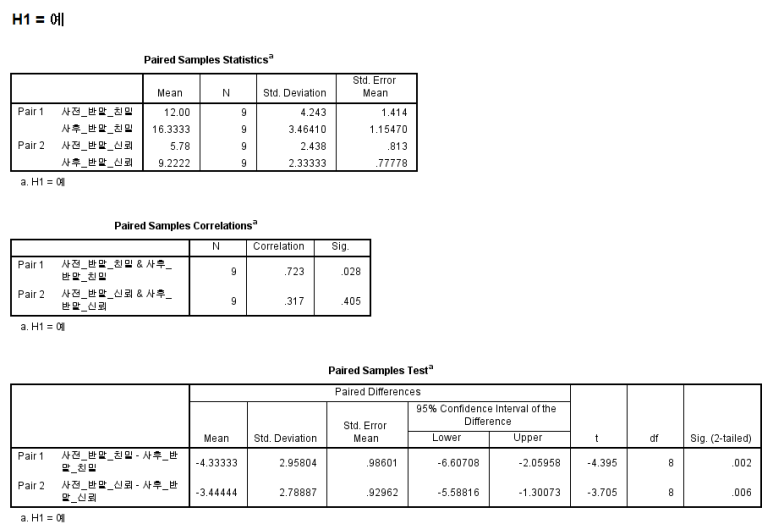

H1: 대화형 인공지능의 존칭 사용 여부에 따라 사용자 친밀감과 신뢰성에 차이가 있을 것이다.

실험집단은 반말을 사용하고, 통제집단은 존댓말을 사용했습니다. 이 경우, 친밀도는 **p < 0.01수준에서, 신뢰성은 ***p < 0.001 수준에서 검증이 되었습니다. 정규성도 만족하고, t-검정의 p값도 유의수준 이내입니다. 네, 이렇게 해서 가설 H1은 참으로 판정되었습니다.

재밌는 게, 실제로 실험을 진행하면서 제가 처치를 한 집단, 그러니까 반말을 한 집단은 "반말하는 인공지능이 더 좋아요."라고 많이 답했고, 존댓말을 틀어준 집단은 "인공지능은 존댓말을 하는 게 더 자연스러워요" 등의 답변을 했습니다. 차이가 분명하죠.

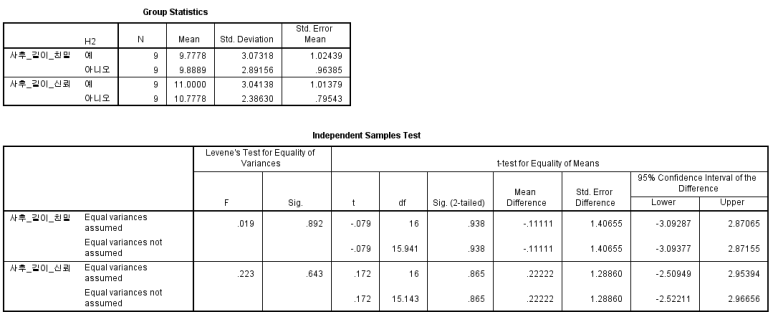

H2: 대화형 인공지능의 답변의 길이에 따라 사용자 친밀감과 신뢰성에 차이가 있을 것이다.

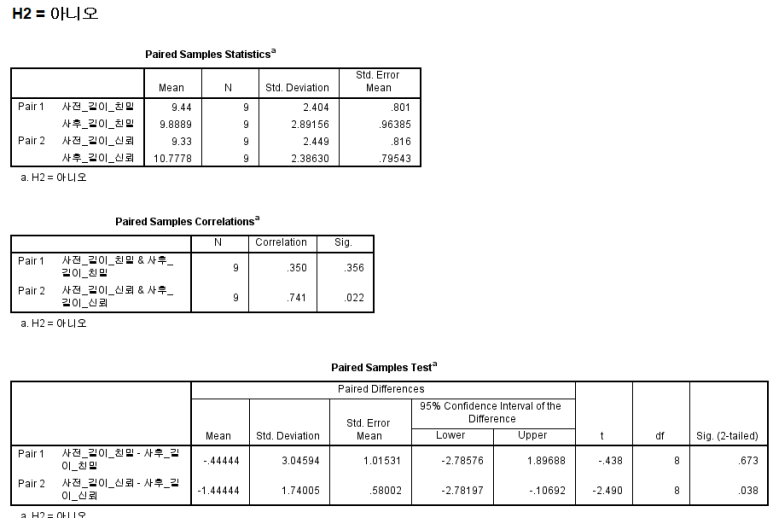

에...이건 기각입니다. 사실 이건 제가 진행을 좀 미숙하게 한 것도 있는데, 참가자가 자신이 통제집단임을 인지하지 못한 상태에서 단순히 답변의 길이에 따른 설문지를 받았으니, 타당도가 떨어졌던 겁니다. 그러니 처치를 하나 안 하나 똑같은 응답이 나올 수밖에 없죠. 이건 나중에 대응표본 t-검정을 다시 하든가 해야겠습니다. 좀 아쉽네요. 유의확률 93.8%의 기적...

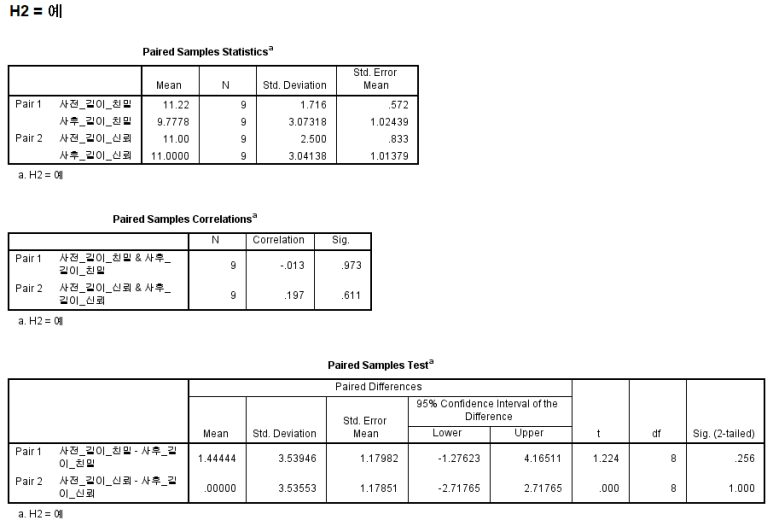

대응표본 t검정을 돌려도 똑같이 기각이네요. 네, H2는 기각입니다. 기각됐다는 게 나쁜 건 아니에요. 어쨌든 검증이 된 거니까요.

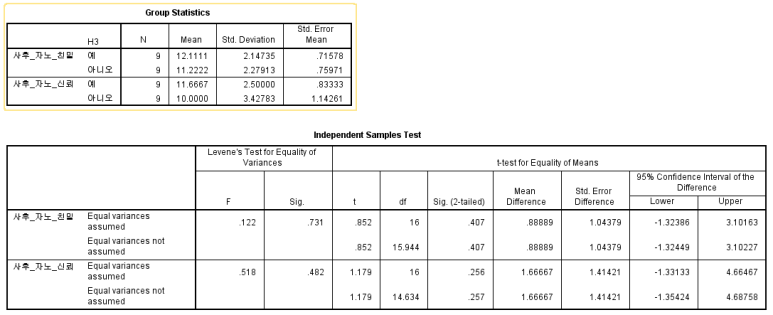

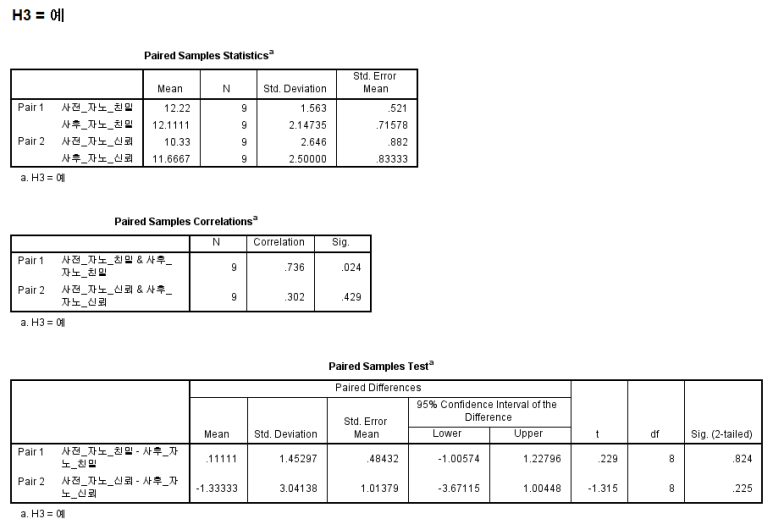

H3: 대화형 인공지능의 자기 노출 정도에 따라 사용자 친밀감과 신뢰성에 차이가 있을 것이다.

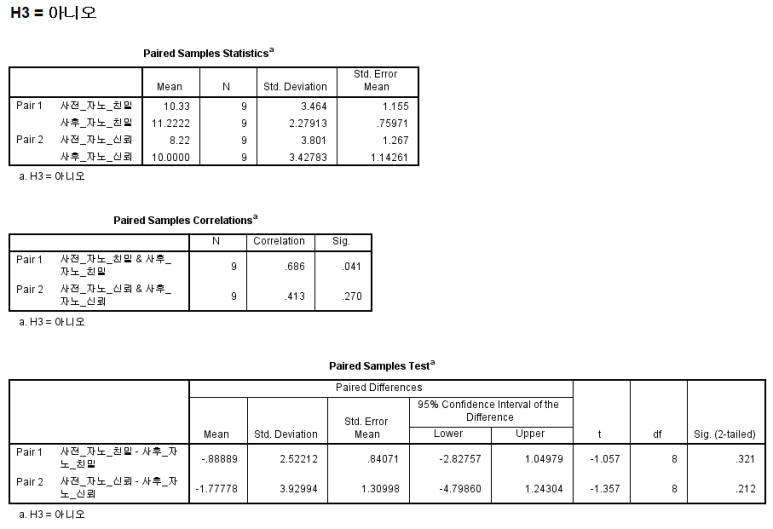

이것도 기각입니다. 자세한 이유는 위와 같아요. 이것도 엄밀하지 못했던 게 한계였던 것 같습니다. 그래도 분명 차이가 존재하기에, 이것도 대응표본 T-검정을 돌리면 뭔가 나오지 않을까 싶긴 해요.

아.... 얘도 기각이네요. H3도 기각입니다.

결론

이번 실험으로 얻은 결론은 다음과 같습니다.

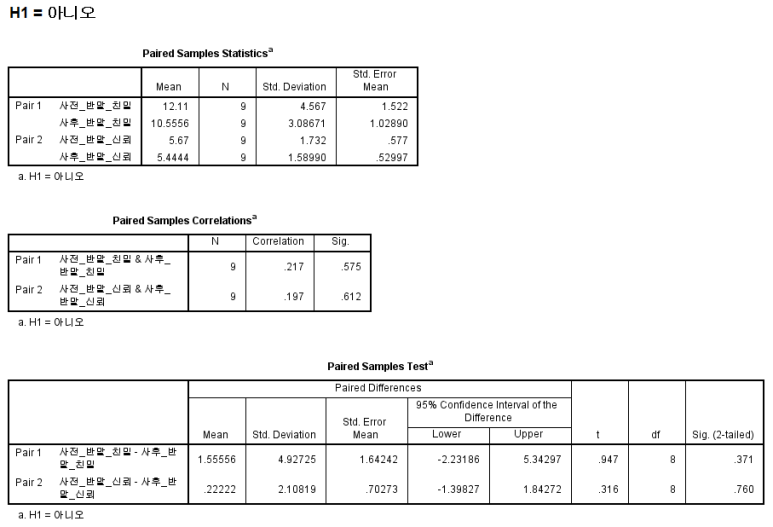

대화형 인공지능의 존칭 표현 사용 여부에 따라 사용자 친밀감과 신뢰성에 차이가 있으며, 존댓말을 사용하지 않았을 때 친밀도와 신뢰성이 올라갑니다. 나머지는 크게 의미가 없었고요. 결론이... 어떤가요? 사실 통제집단이었던 분들은 "엥?" 하실 수도 있어요. 그런데, 막상 대화를 해보면 다르다는 겁니다.

여러분의 처음 응답과 나중 응답을 비교해봤어요. H1을 가지고 대응표본 t-검정을 돌려봤습니다. 왼쪽은 실험집단, 오른쪽은 통제집단이에요. 그런데, 오른쪽은 모두 유의확률이 0.01보다 작습니다. 즉, 기존에 갖고 있던 선입견과 달리, 실제로 반말을 하는 인공지능과 대화를 해보니 친밀감과 신뢰성이 느껴졌다라고 해석할 수 있는 거죠. 그와 달리 존댓말을 사용하지 않았던 통제집단의 경우 실험 전후 모두 일관된 모습(인공지능이 반말을 쓰는 것에 대한 거북함)을 나타내고 있습니다. 신기하죠?

그렇습니다. 예상 외로 결과가 잘 나와줘서 다행이에요. 모두 실험에 참여해주신 여러분들 덕분입니다. 정말 수고 많으셨습니다. 수행평가가 마무리되는대로, 조만간 찾아뵈도록 할게요.

Project Cylinder 진행자, 카루였습니다.

'학교 > Study' 카테고리의 다른 글

| 정적분으로 자연수를 쓸데없이 복잡하게 만들어보자 (0) | 2022.07.17 |

|---|---|

| [미적분] 암기하면 편한 적분 공식들 (0) | 2022.07.17 |

| Project Cylinder 실험 과정 및 절차 안내 (0) | 2022.05.29 |

| [Project Cylinder] 대화형 인공지능 실험 참여자 모집 안내 (0) | 2022.05.29 |

| [사탐방/데이터과학] 4. 회귀분석과 결정계수 R², 추정값 β (0) | 2022.04.20 |

댓글